ニュース

Geek Guild、CES2026でLLMによる生成AIの消費電力を9割減らす「Cache AI」技術を展示

2026年1月6日 08:12

1月4日(現地時間)、米国ネバダ州ラスベガスで世界最大のテクノロジイベント「CES2026」のプレスデーが開始された。プレスデーの初日では、主催者であるCTA(Consumer Technology Association、全米民生技術協会)によるトレンド解説のほか、「CES Unveiled」と名付けられたCES出展社のプレビューイベントがある。

このCES Unveiledには、大手企業からスタートアップまで参加希望の出展社が出ており、さまざまな技術や製品を見ることができる。

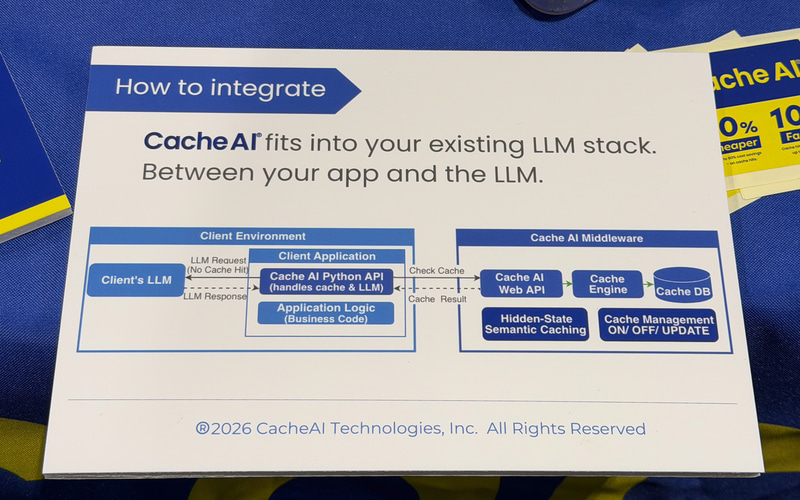

ここに出展していたのが、米国ではCacheAI Technologiesとして活動している株式会社 Geek Guild。出展内容は「Cache AI」と名付けられたキャッシュ技術で、生成AIの消費電力を90%削減し、チャットによる問い合わせ時間(Turnaround Time、TAT)を10倍高速化するものだという。

Cache AI技術を説明していただいた代表取締役 CEO 尾藤美紀氏によると、この技術が特に効くのがOpenAIに代表されるLLM(Large Language Model)タイプの生成AI。生成AIの中での問い合わせと答えをキャッシュに保存することで、生成AIの深部まで探索する必要がなく答えを得られる。

結果的に電力消費が9割減り、10倍高速化するとのことだ。

技術ポイントとしては、生成AI内部にキャッシュロジックを組み込むこと。これにより、幅広い問い合わせ(プロンプト)に対応することができ、キャッシュの効率も上がっているという。同社はこの部分を特許として確立しており、特許確立後に製品化したとのこと。

一般に生成AIというと、クラウドサービスを用いることが多いが、企業などでは外部に企業秘密が漏れてしまうのを防ぐため、自社で生成AIを運用する場合もある。その際に問題となっているのが、生成AIの消費電力問題で、このコストが生成AI運用コストを上昇させ、結果的に企業活動にとって割の合わないものになってしまう。

Cache AIは、そのようなことのない運用を実現し、キャッシュ技術のため結果的に速度も10倍速くなるとのことだ。